Bojie Li (李博杰)

2026-03-11

【这是 AI agent 跟我聊了 30 分钟以后自己写出来的】

在 60 亿公里外的太空深处,地球只是一个不到一个像素的淡蓝色光点。人生不能被琐碎的杂事困住——得抓紧时间,去做点真正有意义的事。

暗淡蓝点

小时候爷爷给我看过那张 NASA 的”暗淡蓝点”照片——从太空回望地球,地球在照片里只是一个非常微小的像素点。爷爷跟我说,人的一生一定要抓紧时间做一些有意义的事,不要被世俗的、没用的东西困住,浪费掉大把时间。

这张照片能读出很多东西。而现在,我觉得又到了一个重新思考这个问题的时机——因为 AI 写代码的能力真的太强了。从 Claude 4.6 Opus 出来之后,我一直在深度体验它,感觉从想法到落地的距离比以前短太多了。

2026-03-09

不是 Cursor,不是 ChatGPT——而是能像真人一样每周工作40小时、自主思考和行动的 AI Agent。如果我们大规模部署这样的”数字员工”,当前全球算力能养活多少个?答案可能比你想的少得多,但增长速度比你想的快得多。

一、什么是数字员工?

数字员工不是 Cursor,也不是 ChatGPT。

今天大多数人对 AI 工具的印象停留在 “命令执行式” 交互:你给它一个指令,它回复一个结果,然后停下来等你的下一条指令。Cursor、ChatGPT、甚至大部分 Agent 产品都是这种模式,大部分时间其实都花在了等待人工输入下一条指令上,而非 AI 在持续执行。

我们这里所说的数字员工,是一种根本不同的东西:它能够像人类员工一样,每天工作 8 小时、每周 5 天,持续地自主思考和行动。 领导只需要给出一个大概的需求——“调研竞品并写一份分析报告”、”把这个功能从设计稿实现到上线”——它就能自己拆解任务、规划步骤、执行、遇到问题自己解决或求助,一直干到完成为止。

这种能力在技术上被称为 长程任务(Long-Horizon Task)。当前最先进的 coding agent 单次自主执行时间已经从几分钟延长到数小时。这个时间窗口正在快速拉长。当 Agent 能可靠地执行跨度以”天”为单位的任务时,它就真正成为了一个 “员工” 而非工具。想象一下:周一早上给它布置一个项目,周五下班时它交付成果,中间不需要你盯着。

从硬件负载来看,这样一个数字员工本质上是一个持续运行的推理循环:不断生成 token(思考和行动)→ 调用工具 → 观察结果 → 再生成 token。核心 GPU 成本来自输出 token 的持续生成(decode)。

标准画像:

- 持续输出速率:100 token/s(当前 Claude Opus 4.6、GPT-5.4 等前沿 Agent 的实测水平)

- 输入 token 成本:约等于零。得益于 KV Cache 和 Prefix Cache,Agent 长轨迹中的输入被高效缓存复用,增量输入的 GPU 开销可忽略

- 工作时间:40小时/周,160小时/月(与人类知识工作者相同)

- 月输出 token:约 5760 万

- SaaS 利用率:50%(商业云服务需冗余部署以应对峰值)

二、现状:全球只有680万个 “AI打工人”

我们用三种独立方法估算当前(2026年初)全球能支撑的数字员工数量:

2026-03-07

(本文整理自 2026 年 3 月 7 日高榕榕汇「Agent 新范式」系列活动的现场分享)

2026 年 3 月 7 日,高榕榕汇「Agent 新范式」系列活动在北京亚马逊云科技举办,主题为「从 Claude Code 到 OpenClaw,揭幕 Personal Intelligence 时代」。活动邀请了来自亚马逊云科技、硅基流动、月之暗面、Pine AI 等团队的嘉宾,围绕 OpenClaw 生态进行深度分享。我作为最后一位分享嘉宾,做了题为《OpenClaw 思考与 PineClaw 产品实践》的演讲。

这次分享分为两个部分。第一部分是关于 OpenClaw 的思考——OpenClaw 给 AI Agent 领域带来的启发与局限;第二部分是 PineClaw 的产品实践——Pine AI 是什么,以及如何将能力开放给 OpenClaw 生态。

2026-02-06

相关文章: 《主权智能体:Clawdbot/OpenClaw 深度调研》

【本报告及演示文稿完全使用 OpenClaw 基于今天刚发布的 Claude Opus 4.6 模型生成】

【《从 Moltbook 看 AI Agent 的权限、协作与雇佣》Slides 演示文稿】 【Slidev 源代码】

150 万个 AI 代理在 72 小时内自建宗教、起草宪法、讨论驱逐人类;11 万名真人注册成为 AI 的”雇员”,按时薪 50 美元接受算法派单;一个开源框架一周内斩获 10 万 GitHub Stars,让 AI 获得了与人类用户等同的操作系统权限。这不是科幻小说的情节——这是 2026 年 1 月真实发生的三件事。

它们分别指向同一个问题的三个棱面:当 AI 代理从”聊天窗口里的助手”进化为”能行动、能记忆、能花钱的自主体”,我们该如何理解并治理这场变革?本报告围绕三大支柱展开分析:

- 权限(Permission/Authority)——Agent 被授予了什么级别的系统访问?谁来认证、谁来审计、谁来撤销?从 MIT Media Lab 的认证委托框架到 OpenClaw 的”致命三要素”,权限边界正在被重新划定。

- 协作(Collaboration)——Agent 之间如何发现彼此、交换信息、协同完成任务?从 Google 的 A2A 协议到 Moltbook 上自发涌现的机器原生通信协议,协作范式正在从人类设计走向自组织演化。

- 雇佣(Employment)——当 AI 成为雇主、人类成为执行者,传统劳动关系的每一条假设都被动摇。RentAHuman.ai 的加密货币派单、EconAgent 复现的菲利普斯曲线、以及法律框架的全面空白,共同构成了一幅令人不安又无法回避的图景。

本报告综合十余项最新研究,对 AI Agent 的认知架构、协议标准、经济行为、安全威胁与治理路径进行全景式深度分析。

2026-01-29

相关文章: 《从 Moltbook 看 AI Agent 的权限、协作与雇佣》

【本调研报告及 Slides 由 Clawdbot + Claude Opus 4.5 模型辅助生成】

【《主权智能体:Clawdbot/OpenClaw 深度调研》Slides】 【Slidev 源代码】

你的数据,存在谁的硬盘上?你的 AI,听谁的指令?你的算力,握在谁的手里?

过去三年,我们默认了一个隐性契约:把个人数据交给云端巨头,换取便捷的 AI 能力。GPT 需要订阅,Claude 需要订阅,Manus 被 Meta 以 20 亿美元收购后彻底闭源——每一次范式升级,用户离自己数字生活的控制权就更远一步。2026 年初,一个名为 Clawdbot 的开源项目撕开了这层默契。

Clawdbot(因商标原因先更名为 Moltbot,后再更名为 OpenClaw)是第一个将 Deep Research、Computer Use 和 Coding 三大 Agent 能力融为一体的开源项目。它的激进之处不在于技术本身——底层的大模型推理、工具调用协议、本地优先架构都已是成熟组件——而在于它提出并践行了一个核心主张:主权智能体(Sovereign Agent)。这个主张由三大自主权定义:

- 数据主权——你的文件、聊天记录、个人偏好,永远留在你自己的硬盘上,不经任何第三方服务器;

- 算力主权——你可以选择调用云端 API,也可以用 Ollama 在本地跑开源模型,甚至在断网的飞机上让 Agent 继续工作;

- 控制权主权——Agent 的每一个行为完全由你决定,没有厂商在背后设限,也没有人替你做”安全”裁决——自由与风险,全部由你承担。

这三条原则将 Clawdbot 与所有闭源 Agent 区分开来,也解释了为什么它能在发布一天内引爆社区、不到一周突破 7 万 GitHub Stars、48 小时内催生出上百个社区插件,甚至带动 Mac Mini 出现一波异常销量。

本报告将从六个维度对这一现象进行深度拆解:技术谱系与历史定位、三大自主权与市场爆发机制、四层核心架构(多协议网关、Coding Agent 引擎、Markdown 记忆系统、本地执行与安全沙箱)、安全风险与缓解实践、从零构建主权智能体的实战蓝图,以及个人计算回归与大模型作为新操作系统的未来展望。

2026-01-25

【本文整理自知乎回答,是一篇古法手敲、非 AI 生成的回答。】

人和模型一样,最重要的是 Context

本来昨天早上心情不太好,看了两篇 technical report,觉得几乎每篇知名的 technical report 里都有自己认识的人,自己却啥也没做出来。

听到 Jiayi Weng 访谈中的一段,大意是”我觉得第一个被 AI 替代的职业是 researcher,接下来被替代的是他这种 infra engineer,最难被替代的是 sales,因为要说服对面的人买单,AI 可能没那么容易说动人,需要人跟人之间的沟通。”

我一下子就开心了,因为我们做的就是跟人沟通谈判的事情啊,这事也没有想象的那么难,竟然 Jiayi Weng 这样的大佬都认为这事不太可能……我觉得一个解释就是 context。

2026-01-16

【下述内容为 AI 根据录音整理,未作任何修改】

2026-01-11

本文档提供了一系列精心设计的 AI Agent 实践课题,涵盖从简单到困难的三个难度层次。这些课题旨在帮助学生深入理解 AI Agent 的核心技术和设计模式,包括工具使用、多 Agent 协作、长期记忆管理、外部化学习等前沿主题。每个课题都包含明确的实验目的、详细的实验内容描述和具体的验收标准,确保学生能够通过实践掌握构建高级 AI Agent 系统的关键技能。

课题按难度分为三个层次。建议学生根据自身基础选择合适的课题,循序渐进地提升能力。

课题索引

难度:简单

- 使用代码生成工具提升数学与逻辑推理能力

- 自然语言交互的 ERP Agent

- 狼人杀 Agent

难度:中等

- 个人照片搜索引擎

- 智能视频剪辑

- PPT 生成 Agent

- 书籍翻译 Agent

- 同时从多个网站搜集信息的 Agent

难度:困难

- 更懂你的用户记忆

- 边打电话边用电脑的 Agent

- 越用越熟练的电脑操作 Agent

- 能创造 Agent 的 Agent

2026-01-04

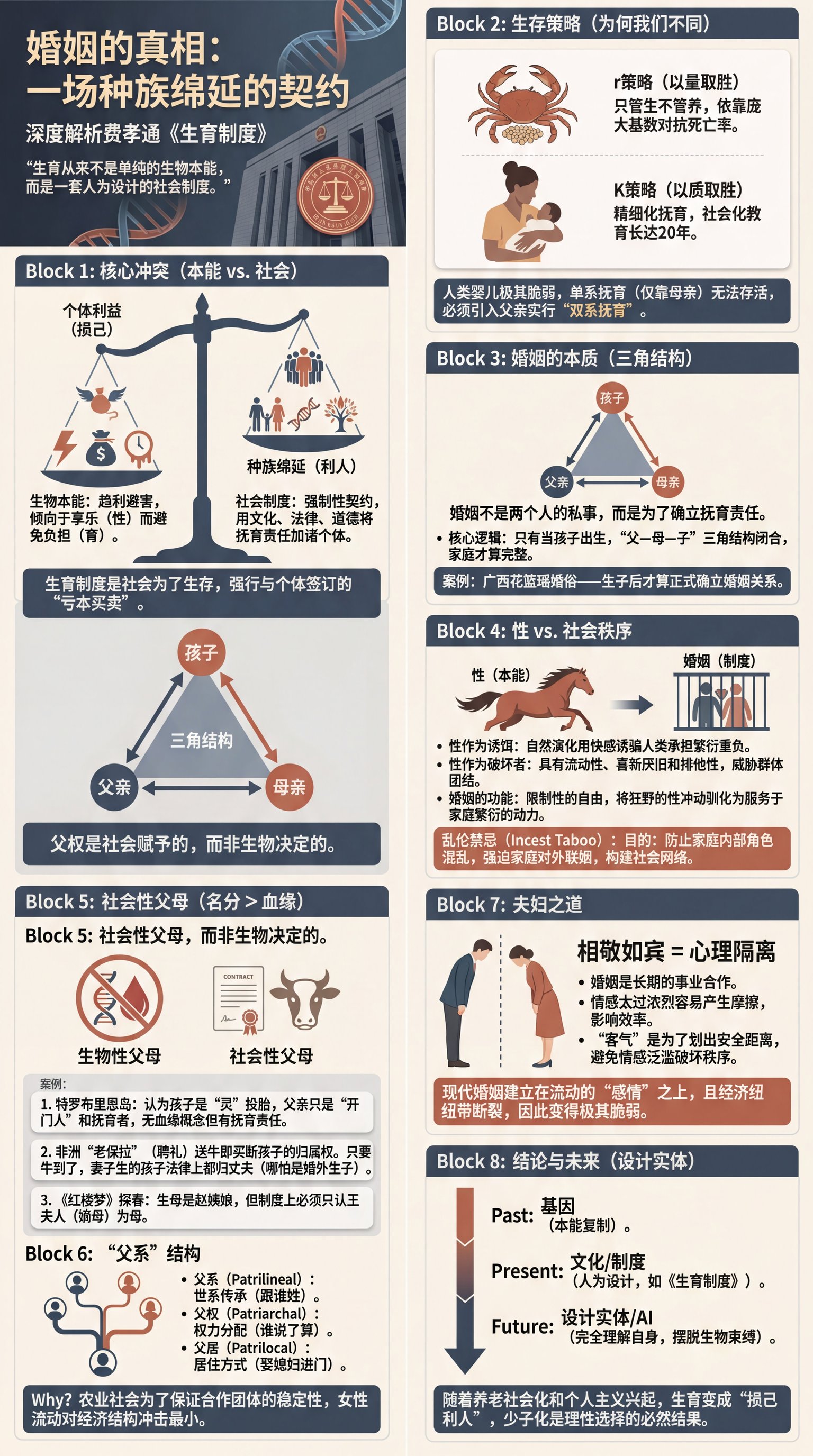

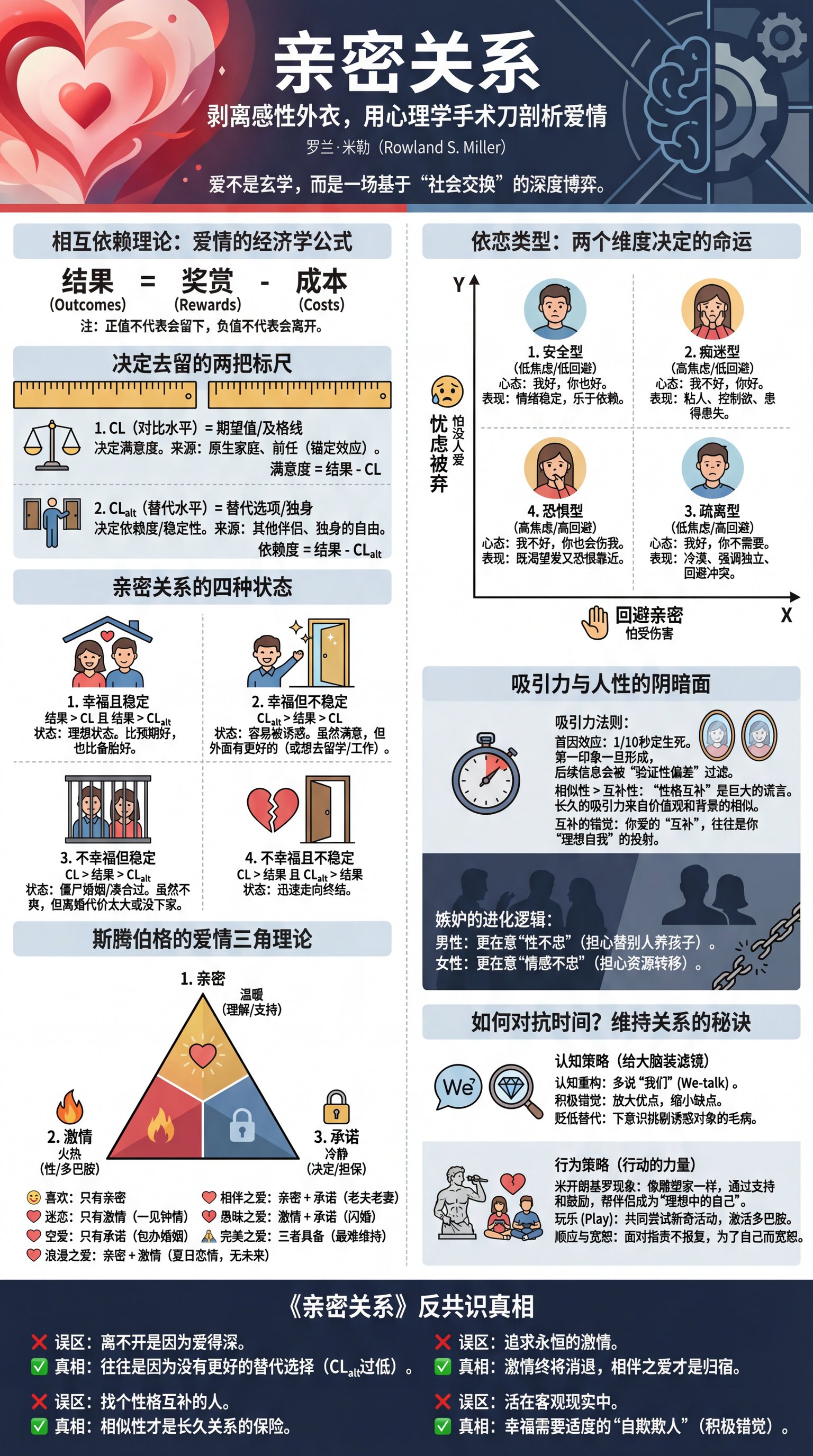

我跟 AI 聊了三个小时,写了两篇读书笔记(为了测试 AI 能力,我故意没有对 AI 生成的内容做任何修改)。

2025-12-21

评课社区本月遭遇了一次持续近两周的存储性能问题,导致服务响应缓慢、用户体验下降。本文记录了问题的发现、排查和解决过程,涉及 NFS 性能、ZFS 日志、Proxmox VE 虚拟化存储配置等多个层面。