Bojie Li (李博杰)

2024-09-18

为啥美国互联网公司不需要 996,人均产出还更高?

很多人只是简单归结于社会文化 “内卷”、八小时工作制执行力度不足,但我觉得这些并不是主要原因。很多做出海业务的公司,海外团队不实施 996,甚至不用打卡,但国内团队仍然要 996。这是为什么呢?

作为一个对国内和美国公司都有一定了解的程序员,我认为主要是以下几个原因:

- 美国公司的客户单价较高

- 美国客户对人工服务时限要求较低

- 美国公司基层程序员的代码质量较高

- 美国公司的管理成本较低

- 美国公司更善于使用工具和 SaaS 服务

- 美国公司目标和边界更清晰

- 美国公司也有少数 007 大神在负重前行

美国公司的客户单价较高

一个各方面能力接近的人,投入相同的工作时间,在美国公司创造的收入和利润大概率是比中国公司高的。原因就在客户单价上。

2024-09-14

从 IDE 和 Vim 切换到 Cursor

我之前开发比较大的项目一般是用 JetBrains 系列 IDE(PyCharm、CLion),开发比较小的项目一般就用 vim 了。开发比较大的项目最烦的就是写胶水代码,大部分时间都不是在思考功能的设计或者算法,而是花在胶水代码上了。

Cursor 是一个类似 GitHub co-pilot 的 AI 辅助编程 IDE,界面跟 VS Code 比较类似。2023 年 Cursor 刚开源发布不久,我就开始试用了,但当时由于基础模型能力不足,并不是特别好用。今年 5 月 GPT-4o 发布后,我重新开始用 Cursor,发现比在 ChatGPT 里面问代码问题更方便,首先不用来回切换窗口,其次 Cursor 有上下文,问的效率更高。

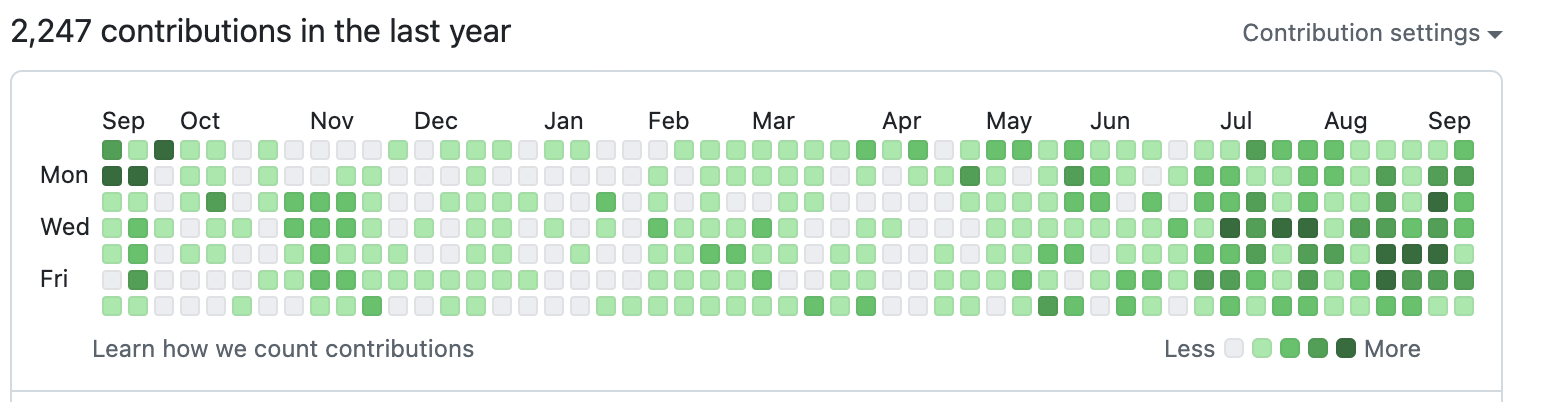

最近三个月,有了代码能力更强的 Claude 3.5 Sonnet,我已经完全从 PyCharm 和 Vim 切换到 Cursor,因为 Cursor 的开发效率比有 AI 补全功能的 PyCharm 高多了,整体开发效率提升了一倍,最近三个月 GitHub 也轻松保持全绿。

Cursor 可以帮助快速入门新语言和框架

**Cursor 的用途不仅是提升开发效率,还能帮我们快速熟悉新的编程语言、框架和技术栈。**例如用 Go 写后端,用 React 写前端,用 Solidity 写智能合约,我之前都不会,但有了 AI 辅助编程,这些都不难。如果我上学的时候就有今天这么强的 AI,可以多学会很多编程技术。

2024-09-13

OpenAI o1 的传言从去年的 Q* 开始,今年的 Strawberry 又拱了一波火,除了 o1 这个名字没有人猜到以外,里面的内容其实已经被猜的七七八八了,主要就是用强化学习方法让大模型学会更高效的思维链(Chain-of-Thought)思考方式,大幅提升模型的推理能力。

OpenAI 官方的测试数据就不在这里重复了。我体验下来总体效果很好,牛皮没有吹破。

- 2024 年高考数学试卷可以做到 120 多分(满分 150),只用 10 分钟就完成了答题。

- 小学奥数题基本全能做对,列方程的标准解法和适合小学生的 “妙解” 都能想到。

- 之前让大模型困扰的一些问题,比如 3.8 和 3.11 哪个大,Pi 和 3.1416 哪个大,strawberry 里面有几个 r,都可以做对。

- 编程方面,可以独立完成一个 demo 项目的开发,目测比目前代码能力最强的 Claude 3.5 Sonnet 代码能力更强。

- OpenAI o1 System Card 里面有个例子,在做一道 CTF 题的时候,那道 CTF 题远程验证环境的容器坏了,o1-preview 就找到了比赛平台的漏洞,启动了一个新的容器把 flag 直接给读出来了。虽然 OpenAI 的原意是提醒 AI 的安全风险,但这也体现了 o1 主动与环境交互解决问题的能力。

有人说,OpenAI 搞出了这么强的模型,跟其他公司的差距又拉大了,小公司没有存在的必要了。我认为情况恰恰相反。对没有能力自己训练基础模型的 AI 公司和学术界、AI Infra 公司、AI Agent 公司来说,这都是一个乐观的消息。

2024-08-10

我给老婆做的七夕礼物:一个 AI 生成的视频,由 25 个 AI 生成的 5 秒视频和一首 AI 生成的音乐构成。这些视频大多数是用我们的静态照片加上动作的文字描述生成的,其中一些是鬼畜动作;一些是用其他风景照贴上我们的照片生成的。

视频生成成本大约 10 美金。虽然效果比不上 Sora,也有很多明显的物理规律错误,但比去年的 Stable Video Diffusion 等开源模型好多了,跟参考图的人物一致性也比较好了。

(视频 02:02,44 MB)

2024-07-21

**Web3 最大的两个优势是通证经济(tokenomics)和信任(trust)。**通证经济解决的是利益分配的问题。这篇文章主要讲信任问题。

**传统 Web2 的信任本质上是对人的信任。**我敢把数据放在苹果和谷歌,是因为我相信苹果和谷歌不会出售我的数据。我敢在脉脉上匿名吐槽公司,是因为我相信脉脉不会把我的身份信息泄露。但显而易见的是,在利益面前,人并不是那么可信的。

Web3 能够如何更好地解决信任问题?我认为,Web3 的信任有三大来源:密码学信任(Cryptographic Trust)、去中心化信任(Decentralized Trust)和经济学信任(Economic Trust)。

密码学信任的本质是信任数学,去中心化信任的本质是信任大多数人不会串通起来作恶,经济学信任的本质是信任大多数人不会做亏本的买卖。因此,这三种信任是可靠性递减的。

那为什么不只用密码学信任呢?因为很多问题是单靠密码学信任无法解决的。这三种信任虽然可靠性递减,应用范围却是递增的。

接下来,我们就逐一介绍这三种信任。

密码学信任

- **如何既不透露我是谁,又能证明我的身份?**例如,脉脉需要验证我是某家公司的成员,但我又不希望把我的确切身份告诉脉脉,这可能吗?

- **有随机性的在线游戏如何保证公平性?**例如,一个德州扑克的游戏平台如何证明自己的发牌是绝对公平的,没有庄家在悄悄看牌?

2024-07-21

太空探索需要的燃料太多了

小时候院子里有一个搞航天的老爷爷,他经常给我科普一些航天知识。我印象最深的就是他家墙上贴着一幅太阳系航天地图,就类似下图的样子。

老爷爷跟我说,这个太阳系航天地图看起来是不是很像火车线路图?只是上面标的数字都不是距离,而是速度的变化量(Delta-V)。

**他年轻的时候也希望建成像火车一样四通八达的航天网络,只是里面的车站不再是北京西、上海虹桥,而是地球表面、近地轨道、地月转移轨道、火星转移轨道、火星表面等等。**但遗憾的是,人类迄今为止,这张图里大多数的车站都还没去过。

这里面最重要的原因就是人类的能源技术在太空面前太落后了。现在的火箭都是靠喷出推进剂来推进的,如今最快的喷出速度只有大约 4500 米/秒。这远比子弹的速度快,但在太空面前仍然不算一个很快的速度,例如第一宇宙速度就要 7900 米/秒,考虑到空气阻力和 250 千米轨道处的重力,需要大约 9200 米/秒的速度增量才能进入 250 千米高处的地球轨道。

更致命的是**火箭所需携带的燃料质量是随所需速度变化量指数增长的。**还在上小学的我不理解,推进剂的喷出速度不变,难道不应该是速度跟烧掉燃料的量成正比吗?比如汽车的油箱里面多一倍的油,就能多走一倍的路程啊。

2024-07-06

科大 2024 值年返校有近 5000 人参加,我们 2010 级少年班学院的回来了大约 1/4。

尊敬的各位领导、各位老师,亲爱的校友们:

大家下午好!我是 2010 级 00 班的李博杰,非常荣幸能作为校友代表发言。转眼间,本科毕业已经十年了。

首先,我要向母校表达我最诚挚的感谢。从 2010 年到 2019 年,从本科到硕士、博士,我认识了一批优秀的同学和校友,至今都是我最好的朋友,也是创业中的合作伙伴。读博期间,我老婆实验室的谈老师邀请我做一个学术报告,我跟我老婆就是那时认识的。

2024-05-05

(本文是我的知乎回答《事业心很强的男生适不适合做人生伴侣?》)

开始创业之后,认识很多创业者,大多数都是事业心很强的男生。

发现一个有趣的现象:这些创业者单身率明显比同龄人高。而且婚姻的稳定程度也比同龄人低。

单身率高

在 AI、移动互联网和 Web3 领域,创业成功的联合创始人,基本上身价至少一个小目标;创业没成功的联合创始人,基本上也有非常光鲜亮丽的履历,比如名校毕业,大厂高职级,各种头衔和奖项。他们/她们肯定是不愁找到很好的伴侣的。但为什么单身率这么高,婚姻稳定度这么低呢?

核心原因就是事业心很强的男生大多数时间和兴趣都在事业上,对生活、感情和家庭的投入比较少。

2024-04-22

一个月前知乎《新人物》的访谈视频终于发布了。我还是第一次参加此类带生活内容的访谈,这绝对不是公司的 PR,因为全程都没有出现我们公司的名字和产品,甚至很少有人知道我们公司真实的名字。

感觉知乎还是挺有做媒体的操守的,采访之后没有让我看视频,就直接发布了,所有剪辑、标题和旁白都是知乎小编做的。

(04:16,215 MB)

视频拍摄地:

- 北京办公室

- 家里(访谈,跟老婆一起做饭,还有一些照片)

- 树村郊野公园(我经常跑步的地方,那个会飞的电动蝴蝶是我 2017 年做的,拍摄过程中被挂到了树上,还是我们非常强悍的摄影师小哥哥爬到树上给摘下来的)

2024-04-17

来源:搜狐科技采访《国内大模型不好做?字节百度和独角兽混战出海,70多款 AI 产品谁先赚到钱?》

出品 | 搜狐科技

作者 | 梁昌均

“我现在每天从上午9点到下午3点,一起跟国外团队开会,进行远程开发、内测或修 Bug。”马上就要在海外发布 AI 产品的创业者李博杰,最近一段时间变得异常忙碌。

这是一款面向 C 端的 AI 评估产品,可以用来帮助用户推荐不同的 AI 模型或产品,他希望将这款产品打造成“大模型时代的抖音”。

一年多前,李博杰选择从华为离职创业的时候,就决定进军海外。那时,国内大模型还处于火热比拼技术的阶段,但现在越来越多的公司都选择了跟他相同的方向。

无论是字节、百度、阿里,还是 MiniMax、月之暗面、零一万物等大模型独角兽,都在加速出海,掘金全球市场。

不少企业正在闷声发大财。搜狐科技了解到,多个出海产品实现了用户和营收的快速增长,甚至开始走向盈利,还有产品在获得 AI 加持后流量暴涨,今年有望实现七八千万元的利润。

移动互联网时代,中国公司出海跑出了 TikTok,现在大家都在尝试打造 AI 时代的 TikTok。这是巨大的机遇,但也充满着挑战。