Bojie Li (李博杰)

2025-04-27

本文是《图解大模型——生成式 AI 原理与实战》一书的配套资料。

我在面试候选人和参加业内研讨会时,常常发现很多人有大量实战经验,但对模型的基本原理知之甚少。为了帮助大家更好地理解本书,也为了方便部分有面试需求的朋友更有针对性地阅读本书,围绕本书各章主题,我系统梳理了大模型领域常见的面试题。其中的大多数问题都可以在书中直接找到答案,部分进阶问题可以从本书的参考文献或网络上的最新论文中找到答案。希望所有的朋友都能够带着这些问题阅读本书。

第一章:大语言模型入门

- Transformer 中的编码器和解码器有什么区别,只有编码器或者只有解码器的模型是否有用?

- GPT 跟原始 Transformer 论文的模型架构有什么区别?

- 仅编码器(BERT 类)、仅解码器(GPT 类)和完整编码器-解码器架构各有什么优缺点?

- 为什么说 Transformer 的自注意力机制相对于早期 RNN 中的注意力机制是一个显著的进步?

- 大语言模型为什么有最长上下文长度的概念?为什么它是指输入和输出的总长度?

- 大语言模型的首字延迟、输入吞吐量、输出吞吐量分别是如何计算的?不同应用场景对首字延迟、输入和输出吞吐量的需求分别是什么?

- 预训练和微调的两步范式为什么如此重要?基础模型通过预训练获得了哪些核心能力?微调在引导模型遵循指令、回答问题和对齐人类价值观方面起到什么作用?

- LLaMA-3 8B 的综合能力比 LLaMA-1 70B 的能力还强,是如何做到的?

2025-04-25

在构建跨地域服务器网络时,例如《搭建全程美国 IP、无需手动设置代理的三层隧道》一文中使用的 VLESS 连接,我们常常会遇到一个效率问题:TCP 协议本身的拥塞控制机制。虽然 TCP 拥塞控制对于公共互联网至关重要,但在已经封装了应用层协议(可能自带流控或拥塞处理)的隧道场景下,外层 TCP 的拥塞控制反而成了累赘。

为什么要在隧道中禁用 TCP 拥塞控制和 Nagle?

- TCP-over-TCP 问题:当你在一个 TCP 连接(例如 VLESS over TCP)内部传输另一个 TCP 连接的数据时,就会出现所谓的 “TCP-over-TCP” 问题。内层 TCP 和外层 TCP 都有自己的拥塞控制和重传机制。当发生丢包时,两个层级的 TCP 都会尝试重传,并且都会缩减拥塞窗口。这种双重处理不仅冗余,而且会导致性能急剧下降,尤其是在高延迟、高丢包的跨国链路上。内层 TCP 的重传计时器可能会因为外层 TCP 的延迟和重传而过早触发,反之亦然,形成恶性循环。此外,TCP-over-TCP 还会导致严重的队头阻塞(Head-of-Line Blocking)问题:外层 TCP 丢失的一个数据包会阻塞其中包含的所有内层连接的数据,即使这些内层连接完全不相关。这意味着一个用户的连接问题可能会影响到共享同一隧道的其他用户。

- 应用层已有流控:隧道中传输的应用层协议可能已经实现了自己的流量控制和可靠性机制。在这种情况下,底层 TCP 的拥塞控制完全是多余的,它只会干扰上层协议的正常工作,限制其性能潜力。

- Nagle 算法的延迟:Nagle 算法旨在通过将小的 TCP 数据包聚合成一个较大的数据包来减少网络中的小包数量,从而提高网络利用率。然而,在隧道场景中,我们通常希望数据能够尽快通过隧道传输,尤其是对于交互式应用(如 SSH)或实时性要求高的应用。Nagle 算法引入的延迟可能会对这些应用造成负面影响。禁用 Nagle(通过

TCP_NODELAY选项)可以让小数据包立即发送,降低延迟。 - UDP 在公共互联网上的困境:你可能会想,既然 TCP 这么多问题,为什么不直接用 UDP 建立隧道连接?不幸的是,UDP 在公共互联网,尤其是跨国链路上,经常受到运营商 QoS(服务质量)策略的限制,优先级较低,更容易被丢弃或限速,导致连接不稳定。因此,在很多情况下,我们不得不选择 TCP 作为隧道传输层协议,这就需要我们想办法优化 TCP 的行为。

因此,对于服务器之间的隧道连接(特别是跨地域连接),禁用外层 TCP 的拥塞控制和 Nagle 算法,可以显著提高隧道的吞吐量和响应速度。

解决方案:一个脚本

2025-04-01

【本文是笔者在 2025 中国生成式 AI 大会 的主旨演讲,演讲内容是笔者与 AI 头脑风暴 2 小时的结果,然后在 Cursor 中与 AI 协作工作 3 个小时精修内容】

内容概要:一些团队在实际应用 AI 编程、 AI 写作时,发现效率提升并没有想象中的大。究其原因,往往是大量的知识仅在特定员工的头脑中,并未文档化,因此 AI Agent 就像一个新来的实习生,很难编写代码,就算是写出了代码,也不知道该如何测试。另一个原因是项目管理等内部工具只能通过 GUI 操作,对 AI Agent 不友好。如今文本推理模型的能力已经达到人类水平,不能完成任务往往是因为缺少背景知识和对 AI 友好的工具。

我们将从软件开发、项目管理、运营三个方面,讲解如何构建一个对 AI Agent 友好的 AI 原生团队。 AI 原生团队需要像开源社区一样,尽量使用有记录的语音和书面沟通,减少对人的单点依赖。 AI Agent 需要能够通过 MCP 访问公司内部的各种工具,有足够的上下文信息和测试环境高效工作。 AI Agent 需要记忆压缩机制、反思机制和检查点回溯机制,才能在无需人类干预的情况下持续工作一晚上,每个小时都产生有用进展。 AI 员工也需要与人类员工和其他 AI 员工主动沟通。这样,人类员工的大多数时间就可以用来做思考和讨论,而大多数重复性的执行工作就交给 AI。

《AI Agent 新探索:构建 AI 原生团队,使能 AI 员工》 PPT 下载(PDF)

以下是演讲全文:(PPT 是 2025 中国生成式 AI 大会上所用的版本,但文字说明并非实录,是笔者与 AI 头脑风暴生成的扩展版本):

封面页

2025-03-14

直播主题:AI Agent,注定爆发?!

时间:2025 年 3 月 13 日 20:00——22:00

方式:极客公园微信视频号「今夜科技谈」直播(连麦)

直播嘉宾:

- 靖宇|极客公园 副主编

- 李博杰|PINE AI 首席科学家

- 宛辰|极客公园 记者

精华要点总结

- AI Agent 的核心特征是具备感知、规划和行动三大能力,能够自主收集信息、制定计划并执行动作

- 像 Manus 一样的通用 Agent 会模仿 “极客程序员” 而非普通人,具备计算思维,懂得何时使用代码和工具解决问题

- 当前 AI Agent 主要分为编译型 (如 Dify) 和解释型 (如 Manus) 两类,编译型是固定工作流,解释型是自主规划决策

- 编译型 Agent 与解释型 Agent 将长期共存,而非相互替代,不同场景有不同的最优解决方案

- 大模型存在 “100 倍成本定律”:芯片公司赚 10 倍,大模型公司再赚 10 倍,这揭示了模型定价与实际成本的巨大差距

- 基础模型是通用 Agent 能力提升的关键,人类很难想象比自己聪明 10 倍的东西,因此不要把人类的思维方式强加给 AI

- Manus 强调的 “Less Structure, More Intelligence” 与经典的《The Bitter Lesson》异曲同工,人类强加给 AI 的结构限制越少,AI 的能力上限就越高

- Claude 3.7 Sonnet 等新一代模型在工具调用和编程能力上有重大突破,为 Agent 发展奠定基础

- DeepSeek R1 的开源使得 RL (强化学习) 技术更易获取,降低了开发高质量 Agent 的门槛

- RL 训练是构建竞争壁垒的重要手段,可以将行业经验和专业知识转化为模型能力

- RL 训练所需的算力门槛没有想象的高,小模型经过 RL 训练后在一些垂直领域的能力可以超过大模型

- 多智能体架构不适合所有场景,在软件开发等领域可能会复制人类组织中的低效协作模式

- AI 编程工具在大型软件工程项目中也可以发挥很大作用,但需要高质量的代码工程基础,包括完善的文档、测试用例和标准化的接口

- 屎山代码 AI 编程工具难起作用,原因与新入职的实习生难以接手一样,都是代码中有太多没有文档化的 tribal knowledge

- Agent 技术的发展将推动软件工程实践的改进,促进代码质量和可维护性的提升,达到知名开源项目的标准,让更多项目变得 AI 友好

- Anthropic 提出的 MCP 协议为 Agent 生态系统的互联互通提供了标准化方案,将使多样化的专业服务相互连接而非相互替代

- OpenAI 的 Responses API、Realtime API 和 Anthropic 的 MCP 代表了 Agent 框架的发展方向

- Agent 的工作效率目前受限于视觉模型的延迟,人类在某些操作速度上仍有优势

- 虚拟机沙盒可以提供独立的工作环境,但需要更好的个人数据集成方案

- AI Agent 未来可能会分为 “快思考” (用户交互) 和 “慢思考” (后台处理) 两个部分协同工作

- 通用 Agent 是硬件、操作系统巨头的兵家必争之地,但大公司发布产品会相对谨慎

- 创业公司在 Agent 领域的机会主要在垂直领域,通过深耕特定场景积累专业数据和行业知识

- 编程、教育和人际沟通是最有可能率先出现成熟 Agent 应用的三大领域

2025-03-14

为什么需要一个三层隧道

你所在的 AI 公司是否经常遇到以下情况?

- 需要访问只对美国 IP 开放的应用或大模型 API,如 OpenAI、Anthropic、Google 等

- 需要连接到美国的公司内网,但不想频繁设置代理

很多人搭建的是应用层代理,那么就需要在环境变量中设置 HTTP_PROXY,HTTPS_PROXY 等,但很多软件并不支持直接用环境变量配置代理,例如:

- Docker 容器内部并不会感知到外部的环境变量,如果要用现成的 docker compose 文件,又想让 docker 内的服务自动用上代理,就要折腾一番了。

- Docker 访问 docker.io 拉镜像和 build image 的时候,需要单独配置代理。

- 各种软件源,例如 pip、npm 等,需要单独配置代理。

- 一些软件,如 Google Cloud CLI,并不会从环境变量中读取代理配置,需要单独配置代理。

- 一些软件,如 Cursor,直接使用 IP 地址访问服务器,且使用的是非标准的 Websocket 协议,一些代理软件不兼容,或容易出问题。

- Node.js 服务端的一些库并不会直接检测 HTTP_PROXY 环境变量,而是需要配置 HTTP Proxy Agent,其中一些库(如 axios)在代理模式下还有 bug。

- 一些编译型语言的代码(如 C++、Go)常常自己组装 HTTP 请求发送,可能根本不支持配置 HTTP 代理。

- 一些 App(如 ChatGPT、Claude Code)使用额外的机制检测网络环境,如果发现代理,可能会拒绝服务,或者降低智商(例如用较差的模型代替 SOTA 模型)。

2025-03-08

【本文首发于知乎回答《如何评价中国团队发布的通用型 AI Agent 产品 Manus?会成为下一个爆款吗?》】

总体来说,我觉得 Manus 是一个 idea 很好,但工程上还有很多打磨提升空间的产品。

关键创新:具备计算思维的 Agent

好多人都觉得它就是个更好的 computer use,其实第一眼我就发现一个根本区别:OpenAI Operator、Anthropic Computer Use 都是模仿普通人,而 Manus 是在模仿极客程序员。

OpenAI Operator / Deep Research 和 Anthropic Computer Use 打开的都是浏览器、桌面 GUI 和移动端 App,最后交付的结果是一段文字(最多带点 Markdown 格式)。而 Manus 一上来打开的是一个命令行终端,在里面用文本编辑器写了个 todo list,干活的过程中不断写代码做自动化,最后的交付件(Artifact)也是一段代码(交互式网页和图表)。

这让我一下子想到了 Jeannette Wing(周以真)博士在 MSR 给我们讲的 Computational Thinking(计算思维)。**计算思维就是把日常生活和工作中的问题抽象化,然后用系统化的逻辑推理和自动化工具解决。**我在科大期间也把计算思维介绍给了很多师弟师妹。

2025-03-08

【转载自网易科技公众号】

原标题为:《Manus 会开启 Agent 元年吗?和大厂离职的两位 AI 创业者聊了聊》

出品 | 网易科技态度栏目

作者 | 袁宁

编辑 | 丁广胜

像一颗巨石投入湖水, Manus 发布溅起的水花虽已逐渐退去,但激起的涟漪还在不断扩散。

Manus 会开启 Agent 元年吗?怎么理解 Agent 及其壁垒?当前是不是 Agent 的发展机会点?不同玩家如何迎接 Agent 的浪潮?当前 Agent 能代替实习生吗……

3 月 8 日,网易科技邀请了两位大厂离职,在 AI 创业一线的嘉宾——李博杰和彭康伟,分享他们的判断与思考。

李博杰,华为“天才少年”出身,曾任华为计算机网络与协议实验室副首席专家,微软学者奖得主。 2023 年投身 AI 创业,目前是 PINE AI 首席科学家,致力于为每个人和每个组织构建类似《Her》 里面 Samantha 的通用智能助理。

彭康伟,曾在腾讯 0-1 打造过月活破亿的 C 端产品, 2023 年离职创业,成立梦马智能,正在做新一代的 AI 内容平台。

作为 AI 浪潮下的创业者,他们如何在巨浪中寻找方向?透过他们的视角,又能看到一个怎样的 Agent 未来?网易科技整理了他们对十个关键问题的回答。

以下内容经《网易科技》不改变原意的编辑:

2025-02-17

【本文转自“蜗壳小道消息” 公众号】

当初只是一个灵光乍现的想法,拉着两个好友,历经两个多月正式上线,就这么在蜗壳存在了十年。

「10 年前」,正逢 2015 年春季学期选课,物理学院大一的张静宁在 QQ 群聊里参与热烈讨论。

“下学期的必修课哪个老师教的好?

“给分怎么样?”

“有没有什么有趣的选修课?”

群聊的生态封闭。讨论者们通常仅能得到一两位学长学姐随手打出的一句评价,犹如盲人摸象。这些只言片语的讨论难以筛选出真正有价值的信息,更难以留存。

张静宁想起了自己上网课(MOOC 课程)的经历:她学习 MOOC 是自发的、主动的。她可以提前了解课程内容、教师风格、课程难度等等,基于自己的兴趣、偏好、需求来选课,在 MOOC 课程的学习上有极强的主动性。

正逢侯建国院士在科大推出《新生“科学与社会”研讨课》,张静宁拉着好友,计算机学院的李博杰和常震,一起开发了 USTC 评课社区,促进校内课程信息公开,帮助学生找到更适合自己的课程。

项目从 2015 年 3 月 8 日开始,到 5 月 25 日发布内测,历时两个多月。

时至今日(2025 年 2 月 17 日),该网站已经持续运行了 3566 天, 14234 位小伙伴们为 17431 门课程贡献了 37176 篇点评。

2025-01-14

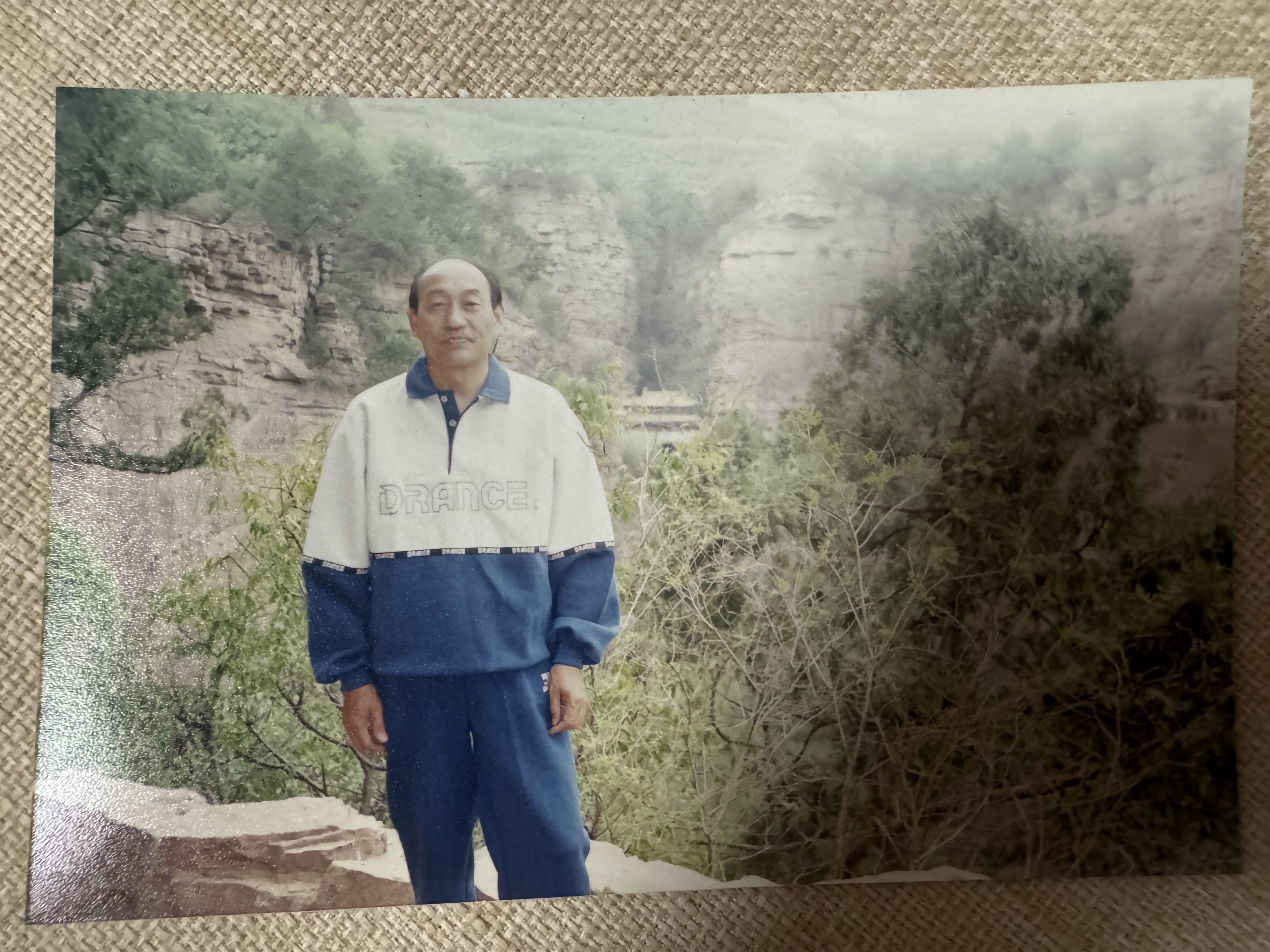

2025 年 1 月 12 日中午 13:00,父亲给我电话,说爷爷中午在家中突然去世了。

爷爷搞地质的一辈子

我爷爷年轻的时候是个学霸,上世纪 50 年代末考上了北京地质学院(中国地质大学的前身),学机械工程专业。那时候北京地质学院是很好的大学,出了很多人才,温总理是他的师弟,“嫦娥之父” 欧阳自远是他的师兄。当然,我爷爷远远不是北京地质学院的杰出校友。大三,赶上中苏交恶,苏联专家全部撤走,没有专家教课了。大四,爷爷进入了中国科学院地理研究所,成为了一名平凡的地质工作者。

爷爷虽然不是跑野外的职位,主要是坐在实验室里搞研究,但也要经常出差到全国各地做地质勘探。地质勘探可不是旅游,风餐露宿是常态。那个年代交通也不发达,光是坐绿皮火车去目的地就要几天。去的地方都是人迹罕至的地方(人多的地方也用不着勘探了),山是野山,水是野水。野外露营的时候遇到野生动物,走到半山腰上遇到地质灾害,都不是什么稀罕事。那个年代可没有手机和 GPS,要是迷路了就交代在山里了。

2025-01-12

【本文首发于知乎回答 《回顾互联网发展,有哪些底层逻辑看似简单但将在未来持续奏效?》】

数据是最重要的护城河。

互联网公司的护城河是数据

我非常喜欢老王的产品课,王慧文是校内、美团创始人之一,他的清华产品课非常经典,值得一遍一遍回味。里面讲到规模效应,社交网络有网络效应。网络效应的背后其实就是数据:我认识哪些朋友?跟这些朋友的亲疏远近怎么样?

老王的产品课里说复制一个微信很难,阿里和字节试图进攻微信但失败了。但如果某天有个先知 app,他知道一个人现实中所有的朋友关系,然后根据这个自动生成好友关系。两个人只要见面聊了几句,不用扫码就能自动推荐好友,当然加不加是用户自己的决定。这个先知 app 恐怕是可以跟微信一战的。这就是微信掌握了好友关系数据的价值。

但这个先知 app 里面没有微信的聊天记录,没有朋友圈的历史,因此还是缺了些什么。这就是对话历史数据的价值。如果这个先知更进一步,知道每个人每天都说了什么,做了什么,那恐怕微信也不是它的对手。